Det er ingen hemmelighed, at AWS-mikrotjenester er et populært værktøj til omkostningsoptimering og skalering, men de er ikke ligefrem et plug-and-play-instrument. At opbygge et helt økosystem, der kører problemfrit og udnytter alle fordelene ved mikrotjenester, er ingen nem opgave. I dag vil JetBase forklare, hvordan man gør det, hvorfor det er det værd, og hvilke udfordringer du kan stå over for undervejs.

Hvorfor ældre systemer holder dig tilbage

At gennemføre en transformation af din arkitektur er en skræmmende opgave, selv med løftet om mikrotjenester på AWS til at ændre din ydeevne. Lad os derfor først fokusere på, hvorfor du skal gøre det, set fra dem med ældre systemers perspektiv.

Ulemperne ved monolitiske arkitekturer

Måske den mest fremtrædende vanskelighed ved at arbejde med monolitisk arkitektur er, hvor stiv den er, og dens mangel på indbyggede skaleringsmuligheder. Vi vil dog afsætte et separat afsnit til dette, og her kan vi adressere andre fejl. For det første kan du kun bruge en enkelt teknologistak, hvilket begrænser din evne til at eksperimentere og bruge forskellige rammer.

Derudover er monolitisk ikke et passende sted at implementere continuous integration/continuous delivery, som er vigtige værktøjer for effektivitet. Endelig gør det samarbejdet vanskeligere, da hele dit team skal have de samme færdigheder, og arbejde på forskellige dele af systemet kan føre til konflikter og fejl.

| Funktion | Monolitisk | Mikrotjenester |

|---|---|---|

| Teknologistak | En på tværs af alle apps | Kan være unik for hver tjeneste |

| CI/CD | Ikke et passende miljø | Understøttes nativt gennem specielt designede AWS-tjenester |

| Fejltolerance | Reduceret, da alle komponenter er afhængige af hinanden for at holde systemet fungerende | Alle komponenter uafhængige, holder systemet kørende, selvom en fejler |

Udfordringer med skalerbarhed og fleksibilitet

I modsætning til AWS-mikrotjeneste-arkitektur har monolitisk arkitektur de samme ressourcer og funktioner, der arbejder på alle processer, hvilket resulterer i et meget stramt ydelsesloft. Det giver stadig mulighed for en vis skalering, men det vil aldrig overgå et system, der fordeler belastningen jævnt. Som et resultat har monolitisk mistet meget af sin popularitet, idet 74% af virksomhederne bruger mikrotjenester.

Introduktion til AWS-mikrotjenester

Nu hvor vi har fastslået manglerne ved det gamle system, lad os tale om løfterne fra det nye. Vi starter med en simpel introduktion til mikrotjenester på AWS og hvad de gør.

Forståelse af mikrotjeneste-arkitektur

Mikrotjenester er en samling af små tjenester, der fungerer uafhængigt af hinanden, hver med fokus på sit eget specifikke formål. De kan nemt ændres, opdateres eller udskiftes uden at påvirke andre dele af økosystemet, hvilket giver virksomheder mulighed for at holde deres drift kørende selv under vedligeholdelse. Denne autonomi muliggøres gennem API-forbindelser og fungerer fantastisk for store virksomheder.

Kernegenskaber ved AWS-mikrotjenester

AWS fører det globale cloud-infrastrukturmarked med omkring 39% af markedsandelen, og dets mikrotjeneste-tilbud drager fordel af samme skala og modenhed. De er også kendetegnet ved deres høje kvalitet og alsidighed. Dette afsnit vil forsøge at fremhæve dem.

Nøgleegenskaber ved mikrotjenester på AWS

Med Amazons ubegrænsede ressourcer kan mikrotjenester på AWS prale af førsteklasses sikkerhed, ved at bruge granulære tilladelsesindstillinger til at kontrollere adgang og køre autorisation gennem mikrotjenester. De er også kendt for fejltolerance, da nedetid for AWS-tjenester er meget sjælden. Listen over væsentlige forstyrrelser er kortere over årtier, end nogle tjenester har på et år.

AWS opfordrer også til CI/CD-integration og fremmer det med hurtige udrulningsværktøjer, hvilket eliminerer behovet for at administrere infrastruktur. Dets spredte økosystem understøtter i stedet dyb sammenkobling med minimal indsats fra brugerne.

Fordele ved at anvende mikrotjenester på AWS

Migration fra monolitisk arkitektur til mikrotjenester er en velundersøgt proces, der kommer med visse forhindringer at overvinde; disse lektioner gælder også for AWS-mikrotjenester. For at give dig lidt opmuntring til det forestående arbejde, lad os tale om alle de fordele, din virksomhed opnår med denne overgang.

Forbedret skalerbarhed og fleksibilitet

Da hver mikrotjeneste er afhængig af sine egne ressourcer, kan du tilføje så mange af dem, som du vil, og udvide dine processer uden at påvirke ydeevnen. Derudover, hvis du beslutter dig for at reorientere, kan hver af disse konfigureres til at tjene et andet formål uden at afbryde andre processer.

Reduceret time-to-market

Sammenligner man almindelig arkitektur og et AWS-mikrotjenesteeksempel, er en af de første ting, der vil slå dig, hvor effektiv udvikling er med sidstnævnte. At kunne iterere hurtigt, producere opdateringer og implementere dem resulterer i hurtigere udgivelser. Så hvis du har en ny funktion og ønsker, at den skal lanceres, før konkurrenterne får chancen for at gøre det samme, vil mikrotjenester hjælpe.

Omkostningseffektivitet med Pay-As-You-Go-modeller

I stedet for at binde sig til et abonnement med høje priser, hvor udgifterne forbliver de samme uanset brug, tilbyder AWS-mikrotjenester en alternativ model. Du kan i stedet vælge kun at betale for de ressourcer, du bruger hver måned. Således vil du skalere dine udgifter passende med din virksomheds vækst og aldrig bruge mere end nødvendigt.

Bedre fejlisolation og modstandsdygtighed

En anden stor forskel mellem monolitisk og mikrotjenester på AWS er, at en del af systemet, der fejler, absolut intet betyder for resten af din infrastruktur. Dit team kan nemt udføre vedligeholdelse på en tjeneste eller udskifte den fuldstændigt uden at andre processer bliver påvirket overhovedet. Som et resultat er dit økosystem meget mindre sandsynligt at opleve nedetid.

Hvilke AWS-tjenester driver mikrotjenester?

Mikrotjenester på AWS har masser af variation, og vi vil gerne fremhæve de centrale, der vil være relevante for de fleste virksomheder:

- Lambda;

- ECS/EKS;

- SQS/SNS;

- API Gateway;

- RDS/DynamoDB.

Uden yderligere omsvøb, lad os dykke ned.

AWS Lambda

Et af de mest kendte AWS-mikrotjenestevalg, Lambda er en eventdrevet tjeneste, ideel til at udføre kode som svar på API-anmodninger, brugerhandlinger og timerbaserede processer. Den er serverløs og kræver ingen indsats fra dig for at skalere dens operationer eller køre den kode, du uploader.

Amazon ECS og EKS

Begge disse hjælper dig i det væsentlige med at bygge og kontrollere containere, selvom EKS er specifikt til Kubernetes-klynger. At holde dine apps containeriseret er fantastisk til privatlivs- og sikkerhedsformål, samt simpel belastningsfordeling gennem ressourcetildelinger. Begge er afhængige af EC2-instanser eller en serverløs Fargate-tjeneste for at fungere, med begge muligheder ganske gode. Fargate er dog bestemt lettere at administrere generelt, mens EC2 er bedst for dem, der søger total kontrol.

Amazon SQS & SNS

AWS-mikrotjenester kan bruges til at sende meddelelser til abonnenter i en flerkanalsstream ved hjælp af Simple Notification Service eller SNS. Det suppleres af Simple Queue Service eller SQS, som giver administratorer mulighed for at planlægge meddelelser, enten til levering til brugere eller til inter-systemkommunikation.

AWS API Gateway

Denne tjeneste er ret grundigt forklaret af sit navn og fungerer som en administrationssuite for API'er i dit økosystem. Den hjælper med at holde opkald sikre, sætte anmodninger i kø efter behov og forbinde klientapps og din backend-infrastruktur. API Gateway automatiserer også belastningsfordeling for at sikre, at dine tjenester aldrig bremses af overvældende trafik.

Amazon RDS & DynamoDB

RDS er ret omfattende, hvad angår AWS-mikrotjenester, og automatiserer database-backups, replikering og skalering. Den tager sig fuldt ud af databaseadministration, så du kan fokusere på andre opgaver. De, der ønsker, at deres database skal være NoSQL og trafikresistent, kan i stedet bruge DynamoDB, som også autoskalerer og har fokus på lav latenstid, hvilket sikrer stabil ydeevne.

| Tjeneste | Formål |

|---|---|

| Lambda | Serverløs kodeudførelse baseret på begivenheder og API-anmodninger. |

| ECS/EKS | Oprettelse af containere for at holde apps uafhængige og private, sikre data mod uberettiget adgang. |

| SQS/SNS | Afsendelse af meddelelser, meddelelseskø, inter-systemkommunikation. |

| API Gateway | Forbindelse med sikkerhedsfunktioner og automatiseret belastningsfordeling. |

| RDS/DynamoDB | Backup-automatisering, replikering og skalering. Funktionalitet til at reducere latenstid. |

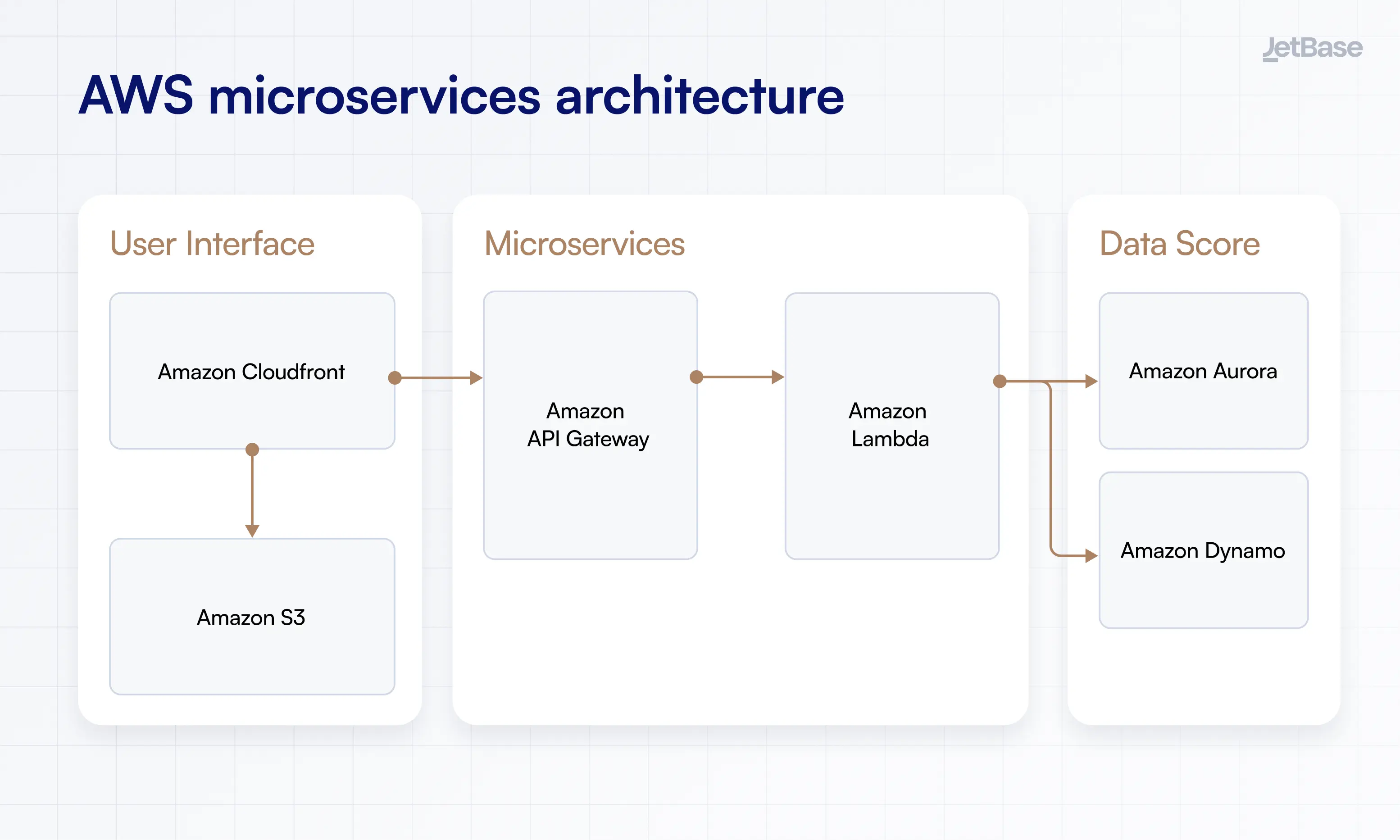

Typisk mikrotjeneste-arkitektur på AWS

Vi vil gerne vise, hvordan mikrotjenester faktisk passer ind i et forretningsøkosystem, inklusive beskrivelser af dets kernellag og et AWS-mikrotjeneste-arkitekturdiagram.

Brugerflade-lag

AWS-mikrotjenestelaget, gennem hvilket dine brugere vil interagere med applikationer og tjenester, som kan omfatte både den visuelle grænseflade og eventuelle tilsluttede enheder. Indhold her administreres via Cloudfront som et Content Delivery Network (CDN), der tilbyder sikker overførsel med lav latenstid. Det bruger også S3 til objektlagring.

Mikrotjeneste-lag

Det faktiske lag af mikrotjenester på AWS har de containeriserede tjenester, der kører dine operationer, ved hjælp af ting som Lambda og Docker. Førstnævnte udfører kode og skalerer den efter behov, mens Docker holder processer uafhængige og sikre fra hinanden.

Datalag og opbevaring

Her vil du gemme data, der er nødvendige for at drive dine apps, og cache dem i hukommelsen for at reducere belastningen på din database. Du får også brug for objektlagring (som S3, vi nævnte tidligere) og en fuldgyldig databasetjeneste som DynamoDB til at gemme data ud over cachen. Dette giver dig mulighed for at være mere fleksibel med lagring uden tab af ydeevne.

Endelig, tag et kig på dette AWS-mikrotjeneste-arkitekturdiagram for at få en visuel idé om, hvordan tingene fungerer.

Sådan bygger du mikrotjenester ved hjælp af AWS

Med lagene af vejen, lad os zoome ind og tale om at etablere den rigtige base for dine mikrotjenester. Dette handler om at optimere AWS-miljøet til dine behov og undgå mulige huller i forbindelsen.

Indledende opsætning og planlægning

Begynd din rejse ind i AWS-mikrotjenester ved at kortlægge de tjenester, du vil bruge, og opsætte den nødvendige AWS-infrastruktur. Dette kan betyde at oprette nok instanser, konfigurere Kubernetes eller ECS og etablere containeriserede rum til dine apps. Gå ikke all-in på én gang, fokusér på kun at etablere de nødvendige mikrotjenester først.

Kommunikation mellem mikrotjenester

Der er tre kernetyper af kommunikation at vælge imellem:

- Synkron;

- Asynkron;

- Hybrid.

Valg og konfiguration af den rigtige database

Dit valg af database vil være delt mellem tre muligheder: SQL, NoSQL og NewSQL. Men odds er, at uanset hvilken type du har kørt før dette, vil være det optimale valg fremover, om ikke andet fordi et skift kan være tidskrævende og kompliceret. Derudover, søg efter databaser, der tilbyder høj ydeevne og lav latenstid.

Når du konfigurerer, skal du vælge, om du vil tildele en enkelt database til hele miljøet eller vælge den mere komplekse model med én database per tjeneste. Dette giver dem mulighed for at være uafhængige og reagere hurtigere på eventuelle anmodninger, de modtager.

Opsætning af AWS DevOps-værktøjer

DevOps kan forbedre de fordele, du får fra AWS-mikrotjenester, og alt det virkelig kræver, er adoption af relevante AWS-værktøjer som CodePipeline, CloudFormation eller Systems Manager. Når du har samlet dine instrumenter, etablerer du versionskontrol for nemt at navigere i ændringer og vende tilbage, når det er nødvendigt. Du skal også overvåge ændringer via CloudWatch, indsamle data og visualisere dem.

Udfordringer ved implementering af mikrotjenester og hvordan AWS adresserer dem

Det er indrømmet, at ikke alt ved mikrotjeneste-arkitektur vil være glat og nemt. Men hvis du bruger AWS, kan du helt sikkert gøre processen lidt mere pålidelig at navigere. Sådan.

Håndtering af komplekse tjenesteinteraktioner

Hvis din intention er at have et system med kompleks sammenkobling, hvor processer muligvis skal kommunikere på uforudsigelige og unikke måder, får du brug for AWS' asynkrone protokoller. Disse vil give tjenester mulighed for at reagere og udføre deres funktion, selvom en del af økosystemet endnu ikke er aktiveret eller slet ikke er involveret i opgaven, hvilket tilsidesætter traditionel logik. EventBridge vil hjælpe med dette og holde alt forbundet uden at kompromittere tjenesternes uafhængighed.

Sikring af sikkerhed og dataintegritet

En af hovedårsagerne til at hoste dine mikrotjenester på AWS er, at den tilbyder omfattende sikkerhedsbeskyttelse og automatiserede overvågningsværktøjer. Som et resultat vil dine data altid være krypterede og sikrede via flertrinsautorisation og adgangsstyringsprotokoller. Dette er essentielt for enhver virksomhed, da datalækager kan være enormt forstyrrende og dyre.

Håndtering af fejl i distribuerede systemer

De, der bruger AWS, anbefales at aktivere request throttling, som hjælper med at undgå netværksforstyrrelser i tider med høj trafik, samt begrænse genforsøgsopkald af samme grund. Det er også bedst at begrænse kø i sådanne scenarier for at undgå at forlænge perioder med høj belastning. Udnyt desuden AWS' automatiserede sikkerhedskopier og ressourceskalering, og lad systemet selv klare enhver overskydende belastning.

Bedste praksis for implementering af mikrotjenester på AWS

Ud over at overvinde udfordringer er her nogle tips til generelt at arbejde med AWS, som vil resultere i et stærkere miljø, der er bedre egnet til dine operationer.

Planlægning af din mikrotjeneste-arkitektur

Du vil sandsynligvis have et ret stort antal mikrotjenester på AWS, hvilket kræver omfattende planlægning for at holde dem alle forbundet. Få dit team til at udarbejde design for arkitekturen på forhånd, diskutere hvilke DB'er der skal vælges, og hvordan brugeranmodninger skal behandles. Mest af alt skal du sikre, at du bruger AWS-funktionalitet til at oprette pålidelige sikkerhedskopier og administrere data.

Sikring af effektiv serviceopdagelse og kommunikation

Brug Amazons ECS til at dirigere navneområder via Cloud Map API, automatisere serviceopdagelse og kategorisere tjenester via separate navne. På denne måde bliver det lettere at etablere kommunikation i batch med alle tjenester i kategorien "BusinessBackend", for eksempel. Cloud Map vil også udføre sundhedstjek for at sikre, at alle tjenester er oppe at køre.

Brug af containere og serverløs til mikrotjenester

At blive serverløs frigør dig fra behovet for at administrere servere, og AWS er glad for at understøtte dette med tjenester som Lambda, der er afhængige af denne model. I mellemtiden vil containere til AWS-mikrotjenester holde dem fungerende uafhængigt og, ved hjælp af kategorier, kommunikere i stor skala uden latenstid eller manuel interferens.

Skalering af mikrotjenester baseret på efterspørgsel

De fleste tilfælde af skalering af mikrotjenester på AWS vil blive automatiseret takket være servicefunktioner, der styrer belastningsfordeling og ressourceskalering, men du kan også foretage horisontal skalering, hvis det er nødvendigt. Dette involverer blot at tilføje flere instanser af en bestemt mikrotjeneste, når det er nødvendigt, hvilket lader AWS yderligere fordele brugerbelastningen i spidsbelastningstider.

| Praksis | Resultat |

|---|---|

| Forudgående planlægning af arkitektur | Evne til at have et indviklet økosystem uden fejl eller latenstids-problemer |

| Styrkelse af opdagelse og kommunikation | Nem kontrol af mikrotjenester med gruppebaseret kommunikation |

| Brug af containere og serverløse tjenester | Holder apps uafhængige og undgår ekstra arbejde relateret til serveradministration |

| Etablering af skalering | Imødekommer enhver mængde trafik selv under spidsbelastningsperioder |

Hvorfor AWS er den ideelle platform for mikrotjenester

Vi har talt om AWS-mikrotjenester med et nærbillede, men lad os zoome ud for en gangs skyld og tale om, hvad der gør AWS til den bedste platform for denne arkitektur. For det første, som vi påpegede ovenfor, har den et absolut væld af tjenester, der passer til dette formål. Med Lambda, EC2, ECS/EKS og andre kan du skabe et vidtstrakt, modstandsdygtigt netværk af mikrotjenester, der kører for din virksomhed.

Dernæst fokuserer AWS på at automatisere mange af de typiske administrationsopgaver, især skalering. Dette er fantastisk, da det giver dit miljø mulighed for at fortsætte med at stige med minimalt input, hvilket opretholder enhver mængde trafik. Det samme gælder for sikkerhed, da AWS leverer alvorlig kryptering og adgangsstyring, der udfører det meste af arbejdet for dig. Kombiner det med brede overvågningsværktøjer, og du har et økosystem, der er skræddersyet til mikrotjenester og virksomheder, der sigter mod vækst.

Har du brug for hjælp til implementering af mikrotjenester på AWS?

Hermed afsluttes vores guide til AWS-mikrotjenester, men det betyder ikke, at vores evne til at støtte virksomheder, der flytter til mikrotjeneste-arkitektur, slutter her. Vi har vist dig, hvor indviklet en mikrotjeneste-opsætning kan være, og de udfordringer, der er forbundet med disse tjenester. Så nu får du brug for teknisk ekspertise til at køre processen korrekt og undgå eventuelle problemer.

JetBase er klar til at være din pålidelige partner i denne opgave, med vores over ti års erfaring i at skabe tilpassede løsninger med fleksibel, modstandsdygtig arkitektur. Vi har brugt AWS til cybersikkerhed og energiløsninger, software til den medicinske industri og videointerview. Denne rige ekspertise er vores stolthed, sammen med vores tætknyttede team, der prioriterer kommunikation og kvalitet.

Så hvis du er klar til en gratis teknisk revision og førsteklasses udvikling, send os en besked.