Det er ingen hemmelighet at AWS-mikrotjenester er et populært verktøy for kostnadsoptimalisering og skalering, men de er ikke akkurat et plug-and-play-instrument. Å sette opp et helt økosystem som kjører knirkefritt og utnytter alle fordelene med mikrotjenester er ingen enkel oppgave. I dag vil JetBase forklare hvordan du gjør det, hvorfor det er verdt det, og hvilke utfordringer du kan møte på veien.

Hvorfor eldre systemer holder deg tilbake

Å gjennomføre en transformasjon av arkitekturen din er en skremmende oppgave, selv med løftet om AWS-mikrotjenester for å endre ytelsen din. Så la oss først fokusere på hvorfor du trenger å gjøre det, sett fra perspektivet til de med eldre systemer.

Ulempene med monolittiske arkitekturer

Den kanskje mest fremtredende vanskeligheten med å jobbe med monolittisk arkitektur er hvor rigid den er og mangelen på innebygde skaleringsmuligheter. Imidlertid vil vi vie en egen seksjon til dette, og her kan vi ta for oss andre mangler. For det første kan du bare bruke én teknologistakk, noe som begrenser muligheten din til å eksperimentere og bruke forskjellige rammeverk.

Dessuten er monolittisk ikke et passende sted for å implementere kontinuerlig integrasjon/kontinuerlig levering (CI/CD), som er viktige verktøy for effektivitet. Til slutt gjør det samarbeidet vanskeligere, da hele teamet ditt vil trenge å ha de samme ferdighetene, og å jobbe med forskjellige deler av systemet kan føre til konflikter og feil.

| Funksjon | Monolittisk | Mikrotjenester |

|---|---|---|

| Teknologistakk | Én på tvers av alle apper | Kan være unik for hver tjeneste |

| CI/CD | Ikke et egnet miljø | Støttes naturlig via spesialdesignede AWS-tjenester |

| Feiltoleranse | Redusert da alle komponenter er avhengige av hverandre for å holde systemet funksjonelt | Alle komponenter er uavhengige, systemet fortsetter å kjøre selv om én feiler |

Skalerbarhets- og fleksibilitetsutfordringer

I motsetning til AWS-mikrotjenestearkitektur, har monolittisk arkitektur de samme ressursene og funksjonene som jobber på alle prosesser, noe som resulterer i et svært stramt ytelsestak. Det tillater fortsatt en viss skalering, men det vil aldri overgå et system som fordeler belastningen jevnt. Som et resultat har monolittisk mistet mye av sin popularitet, med 74 % av selskapene som bruker mikrotjenester.

Introduksjon til AWS-mikrotjenester

Nå som vi har fastslått manglene ved det gamle systemet, la oss snakke om løftene ved det nye. Vi starter med en enkel introduksjon til mikrotjenester på AWS og hva de gjør.

Forståelse av mikrotjenestearkitektur

Mikrotjenester er en samling av små tjenester som opererer uavhengig av hverandre, hver fokusert på sitt eget spesifikke formål. De kan endres, oppdateres eller erstattes enkelt uten å påvirke andre deler av økosystemet, noe som gjør at selskaper kan holde driften i gang selv under vedlikehold. Denne autonomien er mulig gjennom API-tilkoblinger og fungerer utmerket for store bedrifter.

Kjernefunksjoner ved AWS-mikrotjenester

AWS leder det globale markedet for skyinfrastruktur med omtrent 39 % markedsandel, og deres mikrotjenestetilbud drar nytte av samme skala og modenhet. De utmerker seg også med sin høye kvalitet og allsidighet. Denne seksjonen vil ha som mål å fremheve disse.

Viktige kjennetegn ved mikrotjenester på AWS

Med Amazons grenseløse ressurser kan mikrotjenester på AWS skilte med førsteklasses sikkerhet, ved å bruke granulære tillatelsesinnstillinger for å kontrollere tilgang og kjøre autorisasjon gjennom mikrotjenester. De er også kjent for feiltoleranse, da nedetid for AWS-tjenester er svært sjelden. Listen over betydelige forstyrrelser er kortere over tiår enn noen tjenester har på ett år.

AWS oppmuntrer også til CI/CD-integrasjon og fremmer det med raske distribusjonsverktøy, noe som eliminerer behovet for å administrere infrastruktur. Det omfattende økosystemet støtter i stedet dyp sammenkobling med minimal innsats fra brukerne.

Fordeler med å ta i bruk mikrotjenester på AWS

Migrering fra monolittisk arkitektur til mikrotjenester er en godt studert prosess som kommer med visse hindringer å overvinne; disse lærdommene gjelder også for AWS-mikrotjenester. For å gi deg litt oppmuntring til arbeidet fremover, la oss snakke om alle fordelene bedriften din får med denne overgangen.

Forbedret skalerbarhet og fleksibilitet

Siden hver mikrotjeneste er avhengig av sine egne ressurser, kan du legge til så mange du vil, og utvide prosessene dine uten å påvirke ytelsen. I tillegg, hvis du bestemmer deg for å reorientere, kan hver av disse konfigureres til å tjene et annet formål uten å avbryte andre prosesser.

Redusert tid til markedet

Ved å sammenligne vanlig arkitektur med et eksempel på AWS-mikrotjenester, er en av de første tingene som vil slå deg, hvor effektiv utviklingen er med sistnevnte. Evnen til raskt å iterere, produsere oppdateringer og distribuere dem resulterer i raskere utgivelser. Så hvis du har en ny funksjon og ønsker å lansere den før konkurrentene får sjansen til å gjøre det samme, vil mikrotjenester hjelpe.

Kostnadseffektivitet med betal-per-bruk-modeller

I stedet for å forplikte seg til et abonnement med høye priser, der utgiftene forblir de samme uavhengig av bruk, tilbyr AWS-mikrotjenester en alternativ modell. Du kan i stedet velge å betale kun for ressursene du ender opp med å bruke hver måned. Dermed vil du skalere utgiftene dine passende med bedriftens vekst, og aldri bruke mer enn nødvendig.

Bedre feilisolering og robusthet

En annen stor forskjell mellom monolittiske og mikrotjenester på AWS er det faktum at en del av systemet som svikter, betyr absolutt ingenting for resten av infrastrukturen din. Teamet ditt kan enkelt utføre vedlikehold på en tjeneste eller erstatte den fullstendig uten at andre prosesser blir påvirket i det hele tatt. Som et resultat er økosystemet ditt mye mindre sannsynlig å oppleve nedetid.

Hvilke AWS-tjenester driver mikrotjenester?

Mikrotjenester på AWS har massevis av variasjon, og vi vil peke ut de viktigste som vil være relevante for de fleste bedrifter:

- Lambda;

- ECS/EKS;

- SQS/SNS;

- API Gateway;

- RDS/DynamoDB.

Uten videre, la oss dykke rett inn.

AWS Lambda

Et av de mest kjente valgene innen AWS-mikrotjenester, Lambda, er en hendelsesdrevet tjeneste, ideell for å kjøre kode som svar på API-forespørsler, brukerhandlinger og tidsbaserte prosesser. Den er serverløs, og krever ingen innsats fra deg for å skalere driften eller kjøre koden du laster opp.

Amazon ECS og EKS

Begge disse hjelper deg i hovedsak med å bygge og kontrollere containere, selv om EKS er spesifikt for Kubernetes-klynger. Å holde appene dine containerisert er flott for personvern- og sikkerhetsformål, samt enkel lastbalansering gjennom ressurstilordninger. Begge er avhengige av EC2-instanser eller en serverløs Fargate-tjeneste for å fungere, og begge alternativene er ganske gode. Fargate er imidlertid absolutt enklere å administrere totalt sett, mens EC2 er best for de som ønsker total kontroll.

Amazon SQS & SNS

AWS-mikrotjenester kan brukes til å sende varsler til abonnenter i en flerkanalsstrøm ved hjelp av Simple Notification Service (SNS). Den suppleres av Simple Queue Service (SQS), som lar administratorer planlegge meldinger, enten for levering til brukere eller for kommunikasjon mellom systemer.

AWS API Gateway

Denne tjenesten er ganske grundig forklart av navnet sitt, og fungerer som en administrasjonspakke for API-er i økosystemet ditt. Den bidrar til å holde anrop sikre, sette forespørsler i kø etter behov, og koble klientapper og din bakendinfrastruktur. API Gateway automatiserer også lastbalansering for å sikre at tjenestene dine aldri blir bremset av overveldende trafikk.

Amazon RDS & DynamoDB

RDS er ganske omfattende når det gjelder AWS-mikrotjenester, og automatiserer sikkerhetskopiering, replikering og skalering av databaser. Den tar fullstendig hånd om databasestyring, slik at du kan fokusere på andre oppgaver. De som ønsker at databasen sin skal være NoSQL og trafikkresistent, kan i stedet bruke DynamoDB, som også autoskalerer og fokuserer på lav latenstid, noe som sikrer stabil ytelse.

| Tjeneste | Formål |

|---|---|

| Lambda | Serverløs kodekjøring basert på hendelser og API-forespørsler. |

| ECS/EKS | Opprettelse av containere for å holde apper uavhengige og private, sikre data fra uautorisert tilgang. |

| SQS/SNS | Varselsending, meldingskø, kommunikasjon mellom systemer. |

| API Gateway | Tilkobling med sikkerhetsfunksjoner og automatisert lastbalansering. |

| RDS/DynamoDB | Automatisering av sikkerhetskopier, replikering og skalering. Funksjonalitet for å redusere latenstid. |

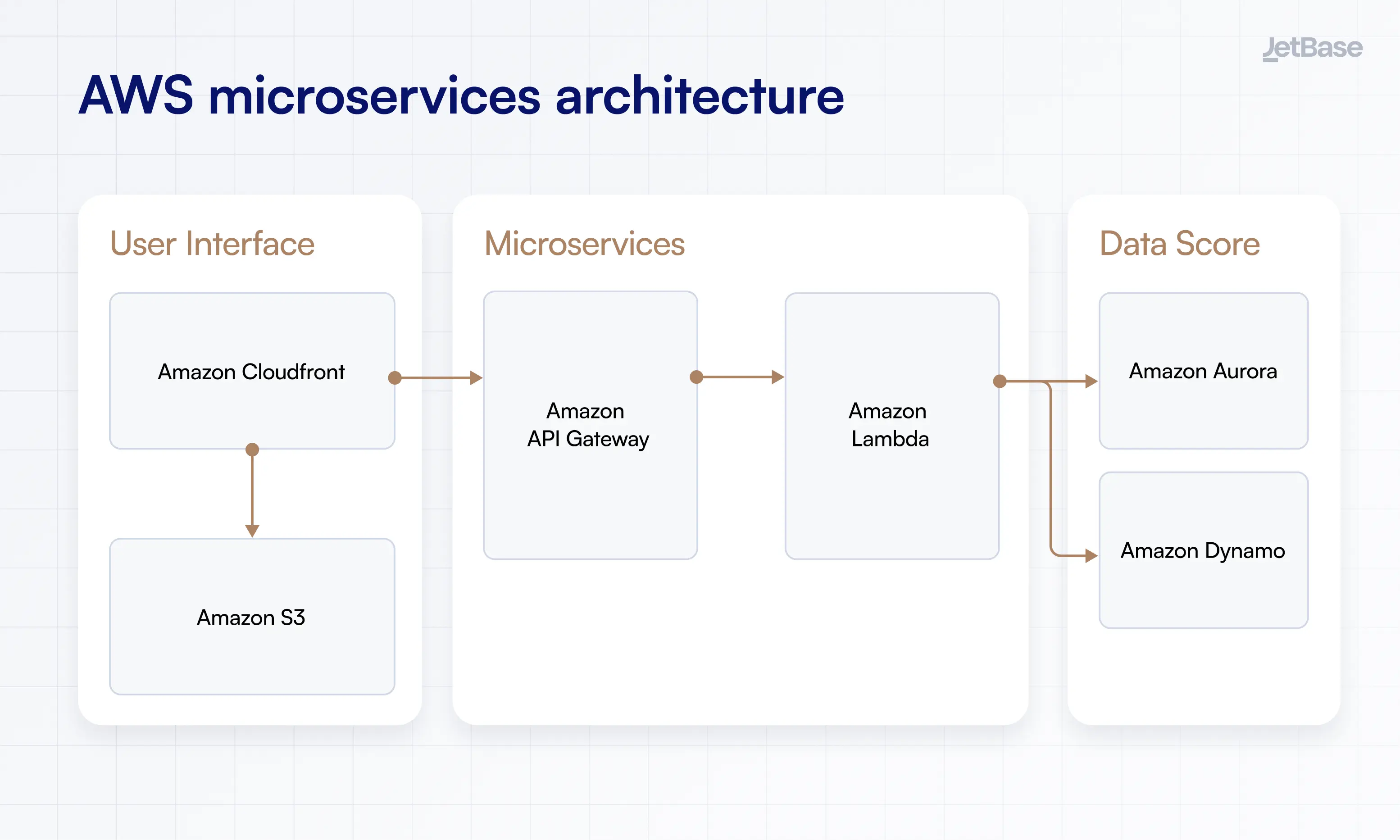

Typisk mikrotjenestearkitektur på AWS

Vi vil gjerne vise hvordan mikrotjenester faktisk passer inn i et forretningsøkosystem, inkludert beskrivelser av kjernekomponentene og et diagram over AWS-mikrotjenestearkitektur.

Brukergrensesnittlag

AWS-mikrotjenestelaget som brukerne dine vil interagere med applikasjoner og tjenester gjennom, som kan inkludere både det visuelle grensesnittet og eventuelle tilkoblede enheter. Innhold her administreres via Cloudfront som et Content Delivery Network (CDN), som tilbyr sikker, lav latenstidsoverføring. Det bruker også S3 for objektlagring.

Mikrotjenestelag

Selve laget av mikrotjenester på AWS har de containeriserte tjenestene som driver operasjonene dine, ved å bruke ting som Lambda og Docker. Førstnevnte utfører kode og skalerer den etter behov, mens Docker holder prosesser uavhengige og sikre fra hverandre.

Datalag og lagring

Her lagrer du data som er nødvendige for å drive appene dine, og cacher dem i minnet for å redusere belastningen på databasen din. Du trenger også objektlagring (som S3 vi nevnte tidligere) og en fullverdig databasetjeneste som DynamoDB for å lagre data utover cachen. Dette gjør at du kan være mer fleksibel med lagring uten ytelsesstraff.

Til slutt, ta en titt på dette AWS-mikrotjenestearkitekturdiagrammet for å få en visuell idé om hvordan ting fungerer.

Hvordan bygge mikrotjenester ved hjelp av AWS

Når lagene er unnagjort, la oss zoome inn og snakke om å etablere det rette grunnlaget for mikrotjenestene dine. Dette handler om å optimalisere AWS-miljøet for dine behov og unngå mulige hull i tilkoblingen.

Innledende oppsett og planlegging

Begynn reisen inn i AWS-mikrotjenester ved å kartlegge tjenestene du ønsker å bruke og sette opp den nødvendige AWS-infrastrukturen. Dette kan bety å opprette nok instanser, konfigurere Kubernetes eller ECS, og etablere containeriserte områder for appene dine. Ikke gå all-in med en gang, fokuser på å etablere kun de nødvendige mikrotjenestene først.

Kommunikasjon mellom mikrotjenester

Det er tre hovedtyper kommunikasjon å velge mellom:

- Synkron;

- Asynkron;

- Hybrid.

Velge og konfigurere riktig database

Ditt valg av database vil deles mellom tre alternativer: SQL, NoSQL og NewSQL. Imidlertid er sjansen stor for at den typen du har kjørt tidligere vil være det optimale valget fremover, om bare fordi bytte kan være tidkrevende og komplisert. I tillegg, se etter databaser som tilbyr høy ytelse og lav latenstid.

Når du konfigurerer, velger du om du vil tilordne en enkelt database til hele miljøet eller velge den mer komplekse modellen med én database per tjeneste. Dette gjør at de kan være uavhengige og reagere raskere på eventuelle forespørsler de mottar.

Sette opp AWS DevOps-verktøy

DevOps kan forbedre fordelene du får fra AWS-mikrotjenester, og alt det egentlig krever er bruk av relevante AWS-verktøy som CodePipeline, CloudFormation eller Systems Manager. Når du har samlet instrumentene dine, etabler versjonskontroll for enkelt å navigere endringer og tilbakestille når nødvendig. Du må også overvåke endringer gjennom CloudWatch, samle inn data og visualisere dem.

Utfordringer ved implementering av mikrotjenester og hvordan AWS løser dem

Riktignok er ikke alt med mikrotjenestearkitektur glatt og enkelt. Men hvis du bruker AWS, kan du absolutt gjøre prosessen litt mer pålitelig å navigere. Slik gjør du det.

Administrere komplekse tjenesteinteraksjoner

Hvis intensjonen din er å ha et system med kompleks sammenkobling der prosesser kan trenge å kommunisere på uforutsigbare og unike måter, vil du trenge AWS' asynkrone protokoller. Disse vil tillate tjenester å reagere og utføre sin funksjon selv om en del av økosystemet ikke er aktivert ennå eller ikke er engasjert i oppgaven i det hele tatt, og unngår tradisjonell logikk. EventBridge vil hjelpe med dette, og holde alt tilkoblet uten å kompromittere tjenestenes uavhengighet.

Sikre sikkerhet og dataintegritet

En av hovedgrunnene til å hoste mikrotjenestene dine på AWS er at den tilbyr omfattende sikkerhetsbeskyttelse og automatiserte overvåkingsverktøy. Som et resultat vil dataene dine alltid være krypterte og sikret via flertrinns autorisasjons- og tilgangsstyringsprotokoller. Dette er viktig for enhver virksomhet, da datalekkasjer kan være massivt forstyrrende og kostbare.

Håndtering av distribuerte systemfeil

De på AWS anbefales å aktivere forespørselsregulering, som bidrar til å unngå nettverksforstyrrelser i tider med høy trafikk, samt begrense antall nye forsøk på anrop av samme grunn. Det er også best å begrense køing i slike scenarier for å unngå å forlenge periodene med høy belastning. Dra nytte av AWS' automatiserte sikkerhetskopier og ressursskalering, og la systemet selv håndtere eventuell overflødig belastning.

Beste praksiser for implementering av mikrotjenester på AWS

I tillegg til å overvinne utfordringer, er her noen tips om generelt arbeid med AWS som vil resultere i et sterkere miljø som er bedre egnet for dine operasjoner.

Planlegge din mikrotjenestearkitektur

Du vil sannsynligvis ha et ganske høyt antall mikrotjenester på AWS, noe som krever omfattende planlegging for å holde dem alle tilkoblet. La teamet ditt tegne opp design for arkitekturen på forhånd, og diskuter hvilke databaser du skal velge og hvordan du skal behandle brukerforespørsler. Fremfor alt må du sørge for at du bruker AWS-funksjonalitet for å lage pålitelige sikkerhetskopier og administrere data.

Sikre effektiv tjenesteoppdagelse og kommunikasjon

Bruk Amazons ECS til å rute navneområder gjennom Cloud Map API, automatisere tjenesteoppdagelse og kategorisere tjenester via separate navn. På denne måten blir det lettere å etablere kommunikasjon i grupper med alle tjenester i for eksempel kategorien «BusinessBackend». Cloud Map vil også utføre helsesjekker for å sikre at alle tjenester er i gang.

Bruke containere og serverløse tjenester for mikrotjenester

Å gå serverløst frigjør deg fra behovet for å administrere servere, og AWS støtter gjerne dette med tjenester som Lambda, som er avhengige av denne modellen. I mellomtiden vil containere for AWS-mikrotjenester holde dem uavhengige og, ved hjelp av kategorier, kommunisere i stor skala uten latenstid eller manuell innblanding.

Skalering av mikrotjenester basert på etterspørsel

De fleste tilfeller av skalering av mikrotjenester på AWS vil være automatisert takket være tjenestefunksjoner som kontrollerer lastbalansering og ressursskalering, men du kan også drive med horisontal skalering om nødvendig. Dette innebærer ganske enkelt å legge til flere instanser av en bestemt mikrotjeneste når det er nødvendig, slik at AWS kan fordele brukerbelastningen ytterligere i rushtiden.

| Praksis | Resultat |

|---|---|

| Forhåndsplanlegging av arkitektur | Evne til å ha et intrikat økosystem uten feil eller latenstidsproblemer |

| Styrke oppdagelse og kommunikasjon | Enkel kontroll av mikrotjenester med gruppebasert kommunikasjon |

| Bruk av containere og serverløse tjenester | Holde apper uavhengige og unngå ekstra arbeid relatert til serveradministrasjon |

| Etablere skalering | Håndtere all mengde trafikk selv under høy belastning |

Hvorfor AWS er den ideelle plattformen for mikrotjenester

Vi har snakket mye om AWS-mikrotjenester med et nært blikk, men la oss zoome ut for en gangs skyld og snakke om hva som gjør AWS til den ideelle plattformen for denne arkitekturen. For det første, som vi påpekte ovenfor, har den et enormt utvalg av tjenester som passer til dette formålet. Med Lambda, EC2, ECS/EKS og andre kan du lage et omfattende, robust nettverk av mikrotjenester som kjører for bedriften din.

Videre fokuserer AWS på å automatisere mange av de typiske administrasjonsoppgavene, spesielt skalering. Dette er flott, da det lar miljøet ditt fortsette å vokse med minimal innsats, og tåle enhver mengde trafikk. Det samme gjelder sikkerhet, da AWS tilbyr seriøs kryptering og tilgangsstyring, og gjør mesteparten av arbeidet for deg. Kombiner dette med omfattende overvåkingsverktøy, og du har et økosystem som er skreddersydd for mikrotjenester og bedrifter som ønsker å vokse.

Trenger du hjelp med å implementere mikrotjenester på AWS?

Dette avslutter vår guide til AWS-mikrotjenester, men det betyr ikke at vår evne til å støtte bedrifter som går over til mikrotjenestearkitektur, slutter her. Vi har vist deg hvor intrikat et mikrotjenesteoppsett kan være og utfordringene knyttet til disse tjenestene. Så nå trenger du teknisk ekspertise for å kjøre prosessen riktig og unngå problemer.

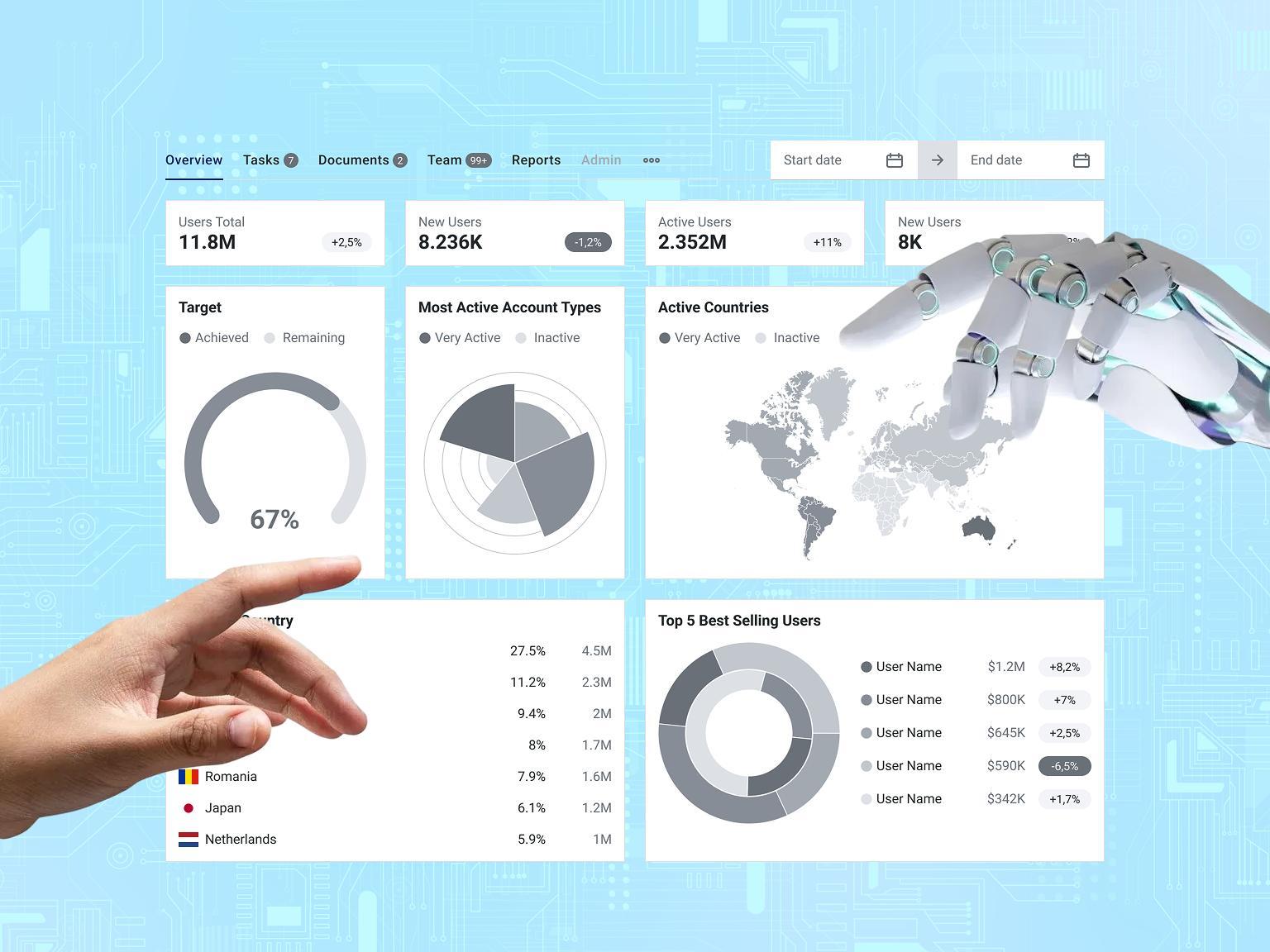

JetBase er klar til å være din pålitelige partner i denne oppgaven, med vår mer enn tiår lange erfaring med å utvikle tilpassede løsninger med fleksibel, robust arkitektur. Vi har brukt AWS for cybersikkerhet og energiløsninger, programvare for medisinsk industri, og videointervjuer. Denne rikdommen av ekspertise er vår stolthet, sammen med vårt sammensveisede team som prioriterer kommunikasjon og kvalitet.

Så hvis du er klar for en gratis teknisk revisjon og førsteklasses utvikling, send oss en melding.